«Apple Intelligence»: Live-Übersetzung, aufgebohrtes «Visual Intelligence» und intelligentere Kurzbefehle

Anlässlich der WWDC25-Keynote und der Vorstellung der neuen OS-Generationen hat Apple auch einige Neuerungen im Bereich «Apple Intelligence» vorgestellt. Die Suite an KI-Funktionalitäten für die Apple-Geräte wird weiter ausgebaut – die persönlichere Siri lässt derweil weiter auf sich warten.

Unsere Sponsoren

-

Apps with love entwickelt digitale Produkte, die das Leben vereinfachen.

-

Dich als Sponsor präsentieren und macprime mit möglich machen.

Live-Übersetzungen für Nachrichten und Telefonate

Apple integriert seine AI-Modelle in die «Messages (Nachrichten)»-, «FaceTime»- und «Phone (Telefon)»-App, um in diesen Live-Übersetzungen von Geschriebenem und Gesprochenem anzubieten.

Nachrichten können bereits während des Tippens übersetzt und in der bevorzugten Sprache der empfangenden Person übermittelt werden – angezeigt wird dann jeweils das Original und die übersetzte Variante. Gleiches gilt auch bei einer Antwort – jede Nachricht kann sofort übersetzt werden. Beim FaceTimen werden «Live Captions» – also quasi «Untertitel» – angezeigt, während die Stimme der sprechenden Person hörbar ist. Beim Telefonieren wird Gesprochenes live übersetzt und direkt ausgesprochen.

Visual Intelligence für Screenshots

Die bei neueren iPhone-Modellen (sprich: iPhone-16-Familie und iPhone-15-Pro-Modelle) verfügbare Kamera-Funktion «Visual Intelligence» wird mit iOS 26 und Co. erweitert – neu gibt es die Funktion nicht mehr nur mit der Live-Kamera, sondern «Visual Intelligence» ist neu auch im Screenshot-Tool verfügbar. Wenn immer ein Screenshot gemacht wird, kann das abfotografierte mit KI-Funktionen weitergenutzt werden.

So können zum Abgebildeten ChatGPT Fragen gestellt werden. Weiter kann die Suchmaschine Google oder auch unterstützte Apps – Apple zeigte während der Keynote vorwiegend «Etsy» – nach Inhalten durchsucht werden, die sich im Screenshot befinden – etwa ähnliche Bilder oder abgebildete Produkte.

Auch kann gezielt nach einem Objekt in einem Screenshot gesucht werden, in dem ebendieses Objekt von der nutzenden Person angemalt und so für die Suche markiert wird.

Wie auch bei «Visual Intelligence» via Kamera, erkennt das System auch in einem Screenshot, wenn dort z. B. im Text oder auf einem Foto ein Event beworben wird – in diesem Falle schlägt das Gerät vor, diesen Event zum persönlichen Kalender hinzuzufügen. Apple Intelligence extrahiert dann das Datum, die Uhrzeit und den Ort, um diese wichtigen Details in das Kalender-Ereignis einzutragen.

Mehr Möglichkeiten mit Genmoji und Image Playground

Mit den neuen Systemen können «Genmoji» nicht mehr nur durch Textbeschreibung generiert werden, sondern neu lassen sich auch mehrere Emojis miteinander kombinieren und mit Beschreibungen «zu etwas Neuem» zusammengestellt werden.

Generierte Bilder aus «Image Playground» und «Genmoji» können neu betreffend Mimik und persönliche Eigenschaften «wie Frisur» angepasst werden – so können auch neue Looks eines Bekannten sofort abgebildet werden.

In «Image Playground» stehen neu Styles via ChatGPT zur Verfügung – von «Ölgemälde» bis zu «Vector Art», so Apple. Weiter kann auch «Any Style» ausgewählt werden, um eine eigene Idee per Beschreibung einfach generieren zu lassen.

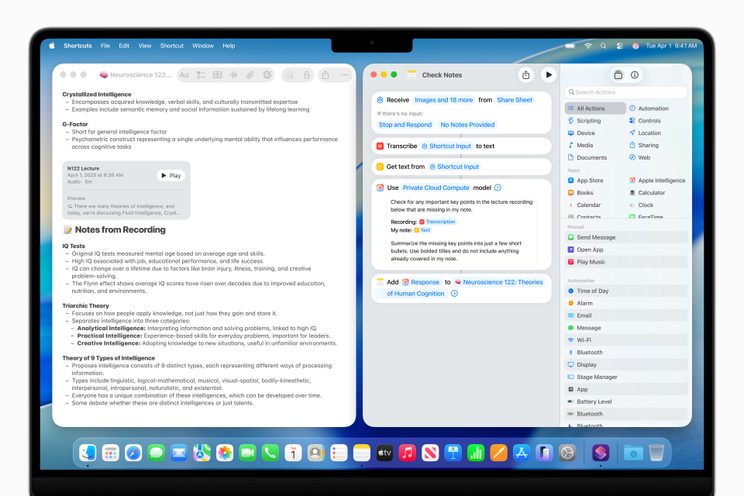

Shortcuts/Kurzbefehle mit neuen Fähigkeiten

Die Automatisierungs-App «Shortcuts (Kurzbefehle)» erhält neu Zugriff auf intelligente Aktionen, die auf Apple Intelligence aufbauen. Dazu gehören etwa das Zusammenfassen von Texten mit den «Writing Tools» oder das Generieren von Bildern via «Image Playground». Ebenfalls neu möglich ist das Zugreifen auf AI-Modelle, die entweder direkt auf dem Gerät oder über die Apple «Private Cloud Compute» ausgeführt werden. Als Beispiel nennt Apple etwa, dass Studis einen Kurzbefehl erstellen können, die Apple-Intelligence-Modelle nutzen, um eine Transkription einer aufgenommenen Vorlesung mit den selbstverfassten Notizen zu vergleichen, um wichtige Punkte automatisch hinzuzufügen, die verpasst wurden, zu notieren. In Kurzbefehle integriert werden kann auch hier ChatGPT.

Für Dritt-Apps und in weiteren Sprachen

Dank neuer API können Entwicklerinnen und Entwickler für Apps neu auf das Apple-Intelligence-Basismodell direkt auf dem Gerät zugreifen – damit stehen leistungsstarke KI-Funktionalitäten, die schnell und datenschutzfreundlich sind, zur Verfügung – auch offline.

Ausserdem werden die Apple-Intelligence-Funktionen noch «vor Jahresende» in acht zusätzlichen Sprachen angeboten – es sind dies Dänisch, Niederländisch, Norwegisch, Portugiesisch (Portugal), Schwedisch, Türkisch, Vietnamesisch und Chinesisch (Traditionell).

Personalisierteres Siri lässt weiter auf sich warten

Gleich Anfangs der Keynote äusserte sich Apples Software-Chef Craig Federighi über den Sachverhalt, dass gewisse Apple-Intelligence-Funktionen, welche eigentlich vor einem Jahr angekündigt wurden, bis dato nicht verfügbar sind. Apple hat bereits offiziell verlauten lassen, dass diese Siri-Erweiterungen sich verspäten und «im kommenden Jahr» lanciert werden. Dazu sagte Federighi jetzt anlässlich der Keynote: «Wir arbeiten weiter daran, die Funktionen bereitzustellen, die Siri noch persönlicher machen. Diese Arbeit benötigte mehr Zeit, um unseren hohen Qualitätsansprüchen gerecht zu werden, und wir freuen uns darauf, im kommenden Jahr mehr darüber zu berichten.»

Gönner-AboAb CHF 5.– im Monat

👉🏼 Wir benötigen deine Unterstützung! Unterstütze macprime mit einem freiwilligen Gönner-Abo und mache die Zukunft unseres unabhängigen Apple-Mediums aus der Schweiz mit möglich.

Kommentare

Anmelden um neue Kommentare zu verfassen

Allegra Leser! Nur angemeldete Nutzer können bei diesem Inhalt Kommentare hinterlassen. Jetzt kostenlos registrieren oder mit bestehendem Benutzerprofil anmelden.